英伟达捅了 AMD 一刀

英伟达捅了 AMD 一刀

留给铁娘子的时间不多了

早在 2015 年,全球 GPU 芯片龙头英伟达的创始人黄仁勋就曾犀利地评价竞争对手 AMD:" 我们已经好多年不看 AMD 的动作了,当(英伟达和 AMD)差距是 9 跟 0 的时候,已经不是差距的问题了。" 在图形显示等 GPU 传统应用市场,英伟达长期占据了 80% 以上的市场份额,将 AMD 远远甩在后头。但随着 AI 大模型时代到来,AMD 正试图凭借空前强大的芯片新品和难得的产业机遇,攻入英伟达的腹地。

" 我在不停打仗 ",在芯片界铁娘子苏姿丰(Lisa Su)的职业生涯里,有两场至关重要的战役。

第一场,是在 2014 年接手 AMD(美国超威半导体),以力挽狂澜之势让 AMD 从深陷财务危机到一举成为英特尔最强劲对手,股价上涨了 40 倍。另一场则是在当下,今年 6 月,AMD 发布了针对 AI 需求的最新款芯片 Instinct MI300,这是其狙击英伟达最强劲的一个武器。

在 GPU 芯片领域,AMD 与英伟达的缘分妙不可言。英伟达与 AMD 长期以 " 八二开 " 的比例瓜分着全球市场份额,在图形显示等市场并称双雄。而媒体则乐于炒作二者更私人的关系——比如,英伟达 CEO 黄仁勋与苏姿丰可能存在的 " 表亲关系 ",当然,双方从未在任何场合正式回应过这些话题。

无论关系如何,黄仁勋一点都不手软,他对铁娘子苏姿丰的第二场战役迅速展开了雷霆反击。

北京时间 11 月 13 日晚间,英伟达发布了全球最强 AI 芯片 H200,其性能较 H100 直接翻倍。打了抢先发布 MI300 的 AMD 一个措手不及。此前,AMD 表示,公司正在今年第三季度向客户提供样品,产量将在第四季增加。原本 MI300 将有望成为 AMD 最快销售额破 10 亿美元的产品。

英伟达称 H200 将在 2024 年第二季度开始交付,留给 AMD 抢跑的时间不多。

AMD 开打第二场 " 翻身仗 "

AMD 还是乐观了。

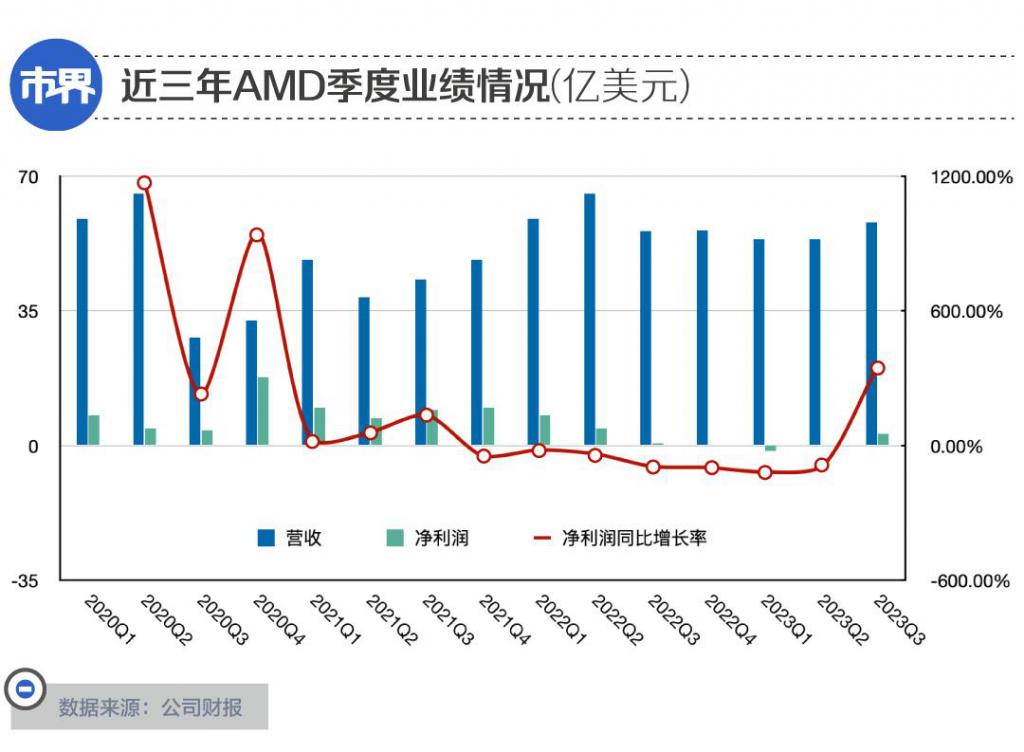

今年 Q3 财报发布之际,AMD 曾大胆给出业绩预期:四季度营收将达到 58 亿美元至 64 亿美元之间,预计为 61 亿美元,同比增长 9% ——这也将是 AMD 自 2022 年第三季度以来,最高的季度收入。

这种预期也可以理解,2023 年第三季度,AMD 营收 58 亿美元,净利润 2.99 亿美元——是连续 7 个季度的净利润同比下滑之后,首次实现季度净利润的同比正增长。

而 AMD 几乎将自己未来业绩强劲增长的底牌,全部押注在了一款产品上:

今年 6 月份,AMD 专门针对 AI 大模型训练需求发布的 Instinct MI300 系列芯片。这几乎是全球范围内,第一款能够直接对标英伟达大模型训练芯片 H100 的产品。

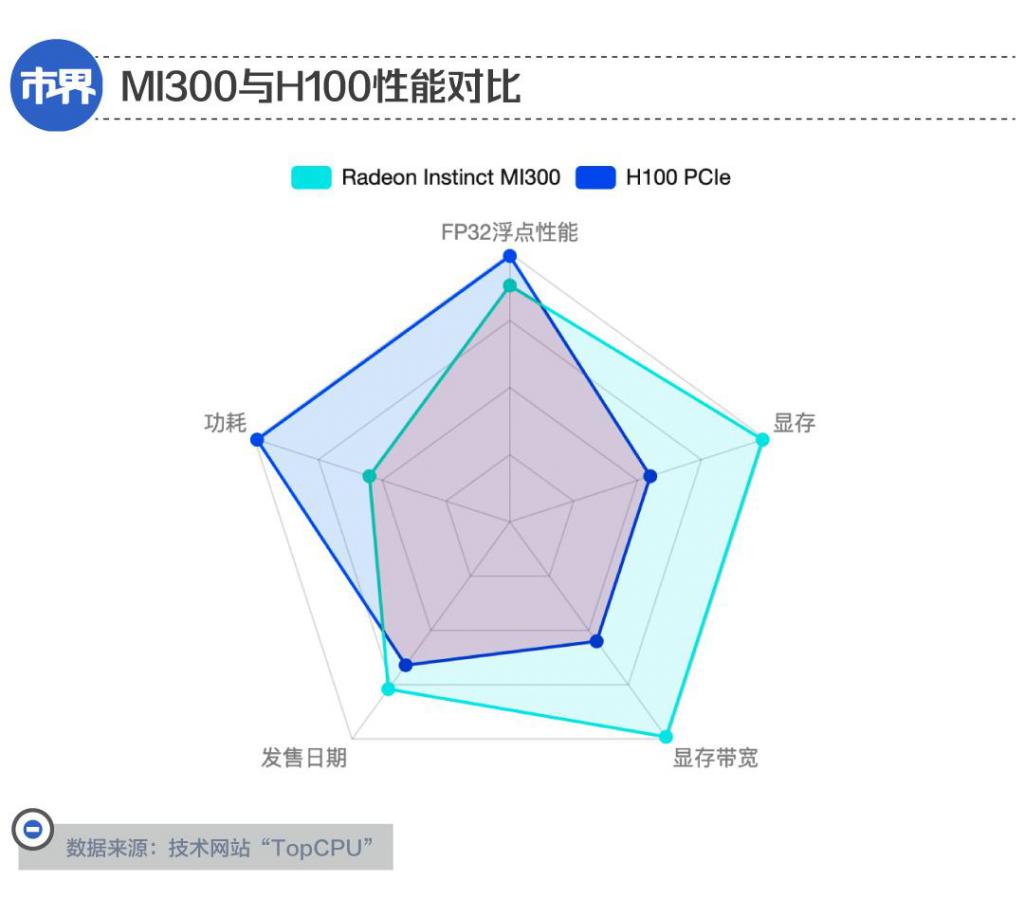

根据 AMD 官方信息,MI300 在部分技术指标上相比英伟达的 H100 更具优势,比如 MI300 提供的 HBM(高带宽内存)密度是 H100 的 2.4 倍,HBM 带宽是 H100 的 1.6 倍。这意味着 AMD 可以运行比英伟达 H100 更大的模型。

惊艳四座的 ChatGPT 大模型大部分基于英伟达 2020 年发布的 A100 芯片进行训练。而在 2022 年 3 月份,英伟达面向 AI 大模型训练需求专门发布了 H100 芯片。

从亮相开始,H100 就迎头赶上了 " 百模大战 " 的风口,成为了被各方力量争夺的宝贵算力资源。据坊间传闻,早在今年第三季度时,英伟达 H100 的订单就已排到了 2024 年,至今产品稀缺程度有增无减。

尽管如此,在发布会上苏姿丰还是表现得十分有信心:" 我们认为,数据中心人工智能加速器 ( 市场 ) 将以超过 50% 的复合年增长率,从今年的 300 亿美元左右增长到 2027 年的 1500 亿美元以上。"

AMD 计划在第四季度量产 MI300。在此基础上,公司预计在第四季度,包含 MI300 在内的数据中心 GPU 业务营收将达到 4 亿美元;而在整个 2024 年,公司数据中心 GPU 产品有望实现 20 亿美元的销售额。

AMD 数据中心 GPU 产品的下游市场既包括科学计算等高性能计算领域,也包括 AI 领域,但苏姿丰认为后者才是业绩的主要增长动力:" 随着 2024 年的到来,我们预计收入将继续按季度增长,而且,这将主要来自人工智能。"

而其中 MI300 被寄予厚望,将成为该公司 " 有史以来最快达成 10 亿美元销售额的产品 "。

此前,AMD 虽然在 GPU 市场名列第二,但主要应用于图形处理、消费级产品等传统 GPU 应用场景,在 AI 和高性能计算领域始终存在感较低。

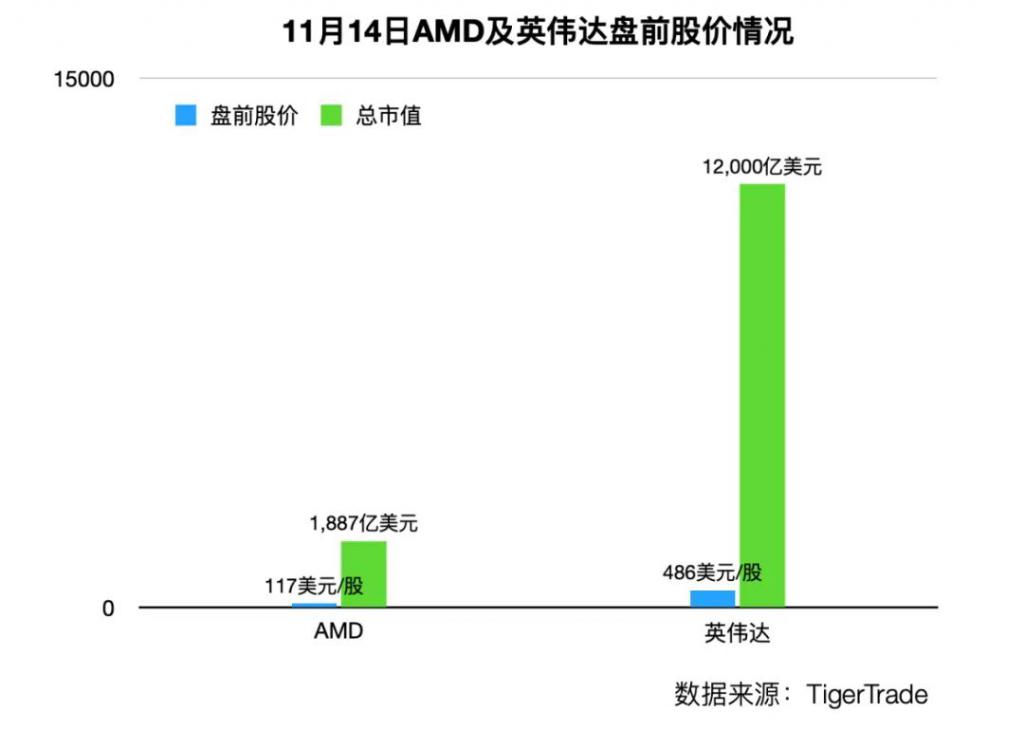

从 MI300 的性能指标而言,AMD 本来已经几乎具备了与英伟达叫板的能力,直到 H200 横空出世。在 H200 发布会结束结束后,AMD 收盘股价下跌 1.52%。

在未来,AMD 想要在如火如荼的 AI 技术市场中抢得一席之地,面前的压力仍毋庸多言。

至今 AMD 尚未公布 MI300 的官方定价,但市场预计,为了增加与英伟达的竞争筹码,AMD MI300 或许不得不延续其在传统 GPU 市场的性价比路线。

不仅如此,为了完成预期业绩,AMD 还于 10 月份在上海启动了一轮裁员 " 瘦身 "。

据一位 AMD 前员工对「市界」透露,本次 AMD 给出的赔偿条件是 "N+3" 倍的月工资,主要涉及的部门为 SoC(系统级芯片技术部门)和 RTG(Radeon 系列显卡技术部门)。

一步慢,步步慢

大模型时代,AMD 等来了一个翻身机遇,只是对这份机遇 AMD 做出的反应还是晚了。

一位在国内高校任职的 AI 研究人员告诉「市界」:" 除了媒体报道的韩国(指该国电信运营商’ KT ’)使用 AMD Instinct 平台运行了 AI 大模型的新闻,在日常研究里,我还没有接触或了解到使用 AMD 芯片训练的项目。"

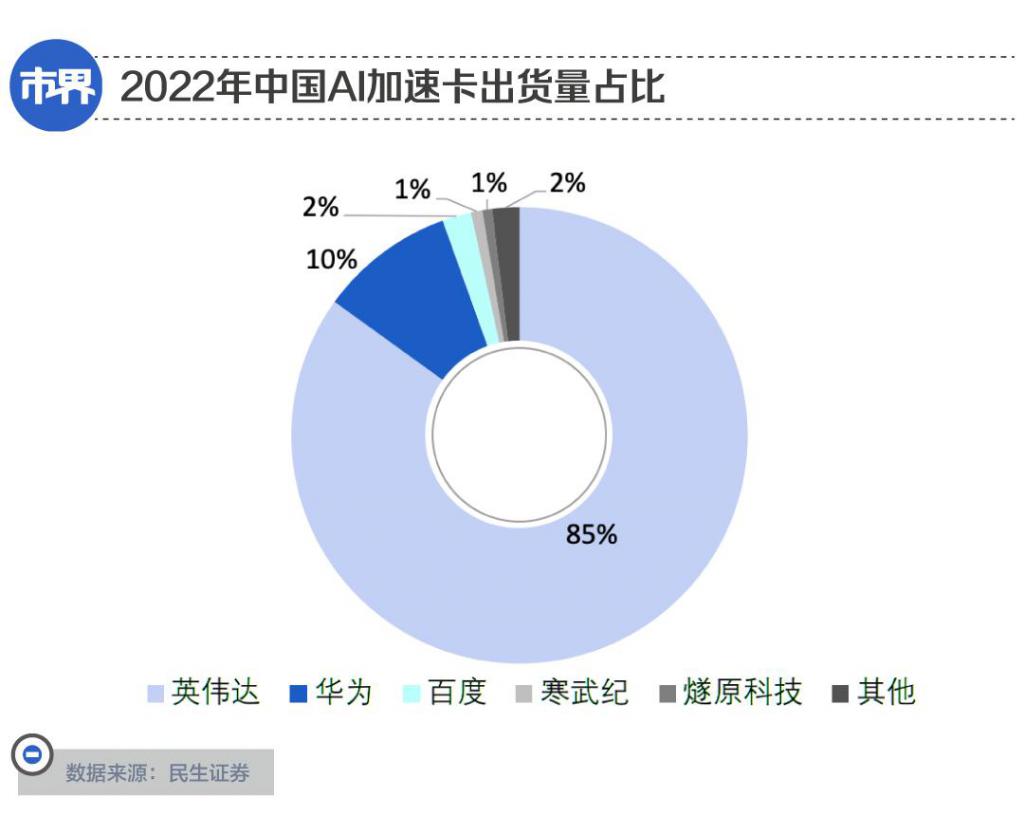

这种情况也反映在了市场数据上,据 IDC 调研,2022 年中国 AI 加速卡(即 AI 训练芯片)出货量约为 109 万张,其中英伟达在中国 AI 加速卡市场份额为 85%,华为市占率为 10%,百度市占率为 2%,寒武纪和燧原科技均为 1%。根据这组数据,AMD 的 AI 训练芯片在国内市场甚至 " 没有姓名 ",沦为其他。

不仅如此,亚马逊 AWS、谷歌、腾讯云等全球主要云厂商的 AI 芯片也大多来自英伟达及自研,采用 AMD 产品的占比较小。

追溯形成显著市场差距的原因,可以将目光转向多年之前。

英伟达创始人黄仁勋曾这样总结:" 我们很早地,大约在 10 年前就发现,(AI)这种制作软件的方式可以改变一切。我们从底层一直到顶层,从各个角度改变了公司。"

在一家美国 GPU 独角兽企业担任市场总监的 Lee 告诉「市界」:" 早在 2012 年,英伟达就开始投入在深度学习的计算了,而且是在全公司范围内贯彻执行。" 而这相较业内普遍意识到 AI 芯片的重要性,至少早了四五年的时间,领先一个身位。

从 2016 年开始,英伟达旗下的加速计算 GPU 产品线(代号 "Tesla")开始专门针对 AI 训练任务进行设计。这一年推出的芯片型号为 P100,同时配备有英伟达新研发的高速互联技术 "NVLink"。而 NVLink 能够允许 CPU、GPU 芯片间进行高速交互,进一步提升了运算效率,至今仍是英伟达 AI 芯片中的核心技术之一。

还是在这一年,英伟达向后来推出了 ChatGPT 的 OpenAI 捐出了一台搭载了 8 块 P100 芯片、价值百万的超级计算机 "DGX-1"。在这台超算的机箱上,黄仁勋亲手写道:" 为了计算和人类的未来,我捐出世界第一台 DGX-1。"

后来的种种迹象都表示,这段时间正是人工智能的黄金发展期。正是在 2016 年,谷歌 Alpha go 击败了围棋大师李世石,被视为 AI 技术迈上新台阶的重要标志。不仅如此,AI 相关产品、硬件、软件等的市场规模已经超过 80 亿美元。

反观同一时期的 AMD,虽然同样试图在 AI 方面有所布局,但彼时其重心更多放在 CPU 业务线上,并未像英伟达一样全面押注。

2016 年,AMD 正式推出 Radeon Instinct 系列产品线,旨在加速深度学习、神经网络和高性能计算等方面应用。

然而从产品更新情况而言,AMD 对旗下 AI 芯片的设计显然不够 " 上心 "。在之后的 4 年间时间里,Radeon Instinct 系列虽然不断更新,但始终与 AMD 的消费级显卡 Radeon 公用基础架构,在计算方面缺乏针对性和高效率,难以满足 AI 训练的需求。

直到 2020 年,这种情况才有所转变。这一年,AMD 将 AI 芯片产品线更名为 "Instinct",并首次抛弃了以往的消费级显卡架构,为其采用了专门设计的 CNDA 计算架构。

在此之后,AMD 连续更新了三代产品 MI100、MI200,以及最新发布的 MI300。凭借全新的技术路线,以及采取高性价比的市场策略,AMD 才开始在 AI 训练市场中有人问津。

只是,在 AMD" 缺席 "AI 市场的几年里,英伟达已经建立起了极强的生态壁垒。

英伟达建筑的高墙

Lee 这样向「市界」描述英伟达在 AI 领域树立的优势:" 真正难的并不是说比别人跑的多快,而是围绕着这一个主题,进行全方位点点滴滴的下注,从语言设计到开发者工具这些周边的东西才是最难得的。"

而周边工具一旦被用户所接受," 客户技术迁移的成本将会是难以想象的高 "。

资深 AI 从业者路云的说法也从侧面印证了这一点,据其回忆:" 早在大约 10 年前,我们学校就给高性能计算相关专业的学生开设了基于 CUDA 的课程。"

CUDA 是英伟达在 2006 年推出的通用并行计算架构,借助 CUDA 提供的编程接口和工具集等,开发者可以基于 GPU 芯片编程、运行复杂的 AI 算法等等。

全球顶尖 AI 学者、前百度首席科学家吴恩达曾这样评价 CUDA:"CUDA 出现之前,全球能用 GPU 编程的可能不超过 100 人,有了 CUDA 之后使用 GPU 就变成了一件非常轻松的事情。"

这样一代代的开发者和研究者,用汗水浇灌出了英伟达的强大生态。换句话说,即使 AMD MI300 的官方性能指标相比英伟达 H100 体现出优势,后者的生态壁垒仍旧难以逾越,更别提 H200 展现出了更强的性能指标。

这样的背景下,AMD 想要逆风翻盘,除了着力补上生态差距,还不得不在市场策略上别出心裁。

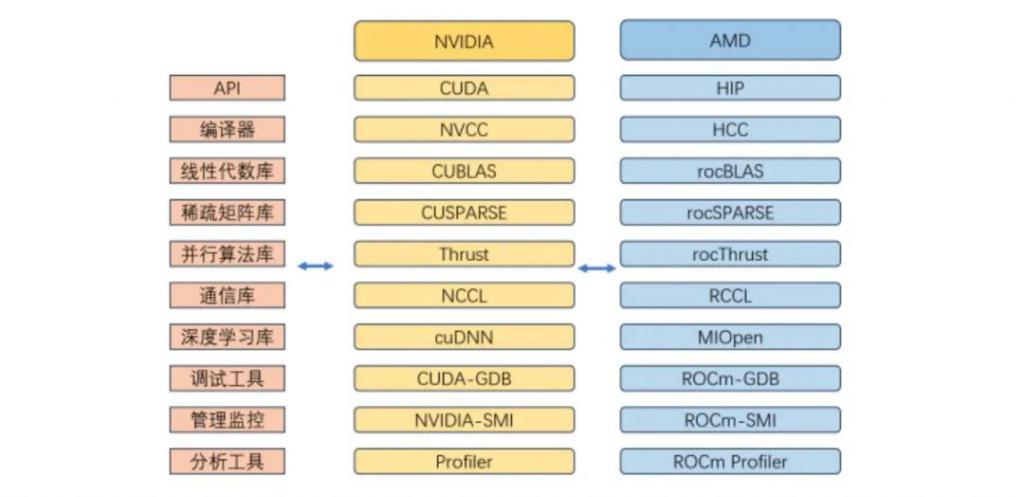

生态方面,2016 年,AMD 推出了对标英伟达 CUDA 的 ROCm 架构。据东吴证券研报,由于 ROCm 平台起步晚,其对于 GPU 加速库的支持没有英伟达 CUDA 全面。CUDA 的应用场景基本能够覆盖全场景,但 ROCm 更多用于高性能计算领域,对 AI 的覆盖稍显不足。

至今,AMD ROCm 平台的工具链已经相对完善,并且能够兼容英伟达的 CUDA 平台。此外,为了进一步优化软件生态,AMD 还在 2023 年 10 月份官宣收购了 AI 软件企业 Nod.ai。

对此东吴证券研报评论道:AMD 的软件生态在公司大力投入和其它厂商积极扶持下,有望彻底改善。

(英伟达与 AMD 软件生态工具链完善程度对比。图源 / 东吴证券)

另一方面,AMD 高性价比的市场策略将是其在 AI 领域的另一大优势。联博资产管理公司的分析师 Stacy Rasgon 认为,提供’平替版的英伟达’,将是 AMD 争取市场支持的关键。

AI 研究公司 Cambrian AI Research 则分析称,大公司需要 " 第二供应商 " 的战略将为 AMD 提供机遇:" 像 OpenAI 和微软这样的公司需要有一个能替代英伟达产品的选择,AMD 可能会给他们一个无法拒绝的提议,但不要指望能从英伟达那里抢走很多份额。"

无论如何,大模型产业疾速发展带来了巨大的算力缺口:根据 OpenAI 数据, 模型计算量增长速度远超人工智能硬件算力增长速度,两者之间存在万倍差距。

对于长期在 AI 领域缺乏存在感的 AMD 而言,它正迎来了最好时机。

-

- 阿里全系产品崩了,谁会是阿里云的解铃人?

-

2023-11-16 14:07:04

-

- 秋后算账,无限追责……他们的地曾经也毒过

-

2023-11-16 14:04:48

-

- 前副总裁被列“七宗罪”,罗永浩和交个朋友“交友不慎”?

-

2023-11-16 14:02:32

-

- 闺蜜生日祝福语简短暖心句子怎么说?闺蜜生日简短洋气句子有哪些?

-

2023-11-16 14:00:16

-

- 荷花文案高级短句 荷花文案短句干净

-

2023-11-16 13:57:59

-

- 花果山在什么地方?花果山在哪个省哪个市?

-

2023-11-16 13:55:43

-

- 美方多位高级官员机场迎接习近平主席

-

2023-11-15 14:39:38

-

- 最新消息!成都被狗咬伤女童已出院

-

2023-11-15 14:37:22

-

- 百岁老师生病住院 7 旬学生手捧鲜花探视

-

2023-11-15 14:35:06

-

- 国台办:“台独工作者”就是战争制造者

-

2023-11-15 14:32:50

-

- 男子误吞枣核胃镜下意外发现胃癌

-

2023-11-15 14:30:34

-

- 又降价了!大闸蟹每只跌破 10 元!为什么

-

2023-11-15 14:28:18

-

- 网友吐槽政务大厅全天工作 6 个小时,回应来了

-

2023-11-15 14:26:02

-

- 沸腾了!刚刚,刘德华官宣

-

2023-11-15 14:23:47

-

- 巴以冲突中遇难工作人员超百名,联合国多地机构降半旗并默哀

-

2023-11-15 01:34:49

-

- 余承东发朋友圈:智界 S7 预定过万 比问界新 M7 还猛

-

2023-11-15 01:32:33

-

- 华为多款产品涨价!Mate X5 涨价 1000 新平板涨 500

-

2023-11-15 01:30:18

-

- 美军轰炸叙利亚目标后,驻叙美军不到24小时内遭到4次袭击

-

2023-11-15 01:28:02

-

- 李开复旗下 AI 公司 “零一万物” 开源 Yi 大模型被指抄袭 LLaMA

-

2023-11-15 01:25:46

-

- 长江安庆河段治理工程开工,系国家150项重大水利工程之一

-

2023-11-15 01:23:31

世界综合国力排名(联合国五常综合实力大排名)

世界综合国力排名(联合国五常综合实力大排名) 2023年十大高产玉米品种(排名第一的玉米品种名字)

2023年十大高产玉米品种(排名第一的玉米品种名字)